- A generalized multi-task learning approach to stereo DSM filtering in urban areas. ISPRS Journal of Photogrammetry and Remote Sensing 166, 2020, 213-227 more… Full text ( DOI )

- Multitask Learning for Human Settlement Extent Regression and Local Climate Zone Classification. IEEE Geoscience and Remote Sensing Letters, 2020, 1-5 more… Full text ( DOI )

- Multi-Task cGAN for Simultaneous Spaceborne DSM Refinement and Roof-Type Classification. Remote Sensing 11 (11), 2019, 1262 more… Full text ( DOI )

- MultiDepth: Single-Image Depth Estimation via Multi-Task Regression and Classification. IEEE Intelligent Transportation Systems Conference (ITSC), IEEE, 2019, 1440-1447 more… Full text ( DOI )

- Auxiliary Tasks in Multi-task Learning. arXiv preprint arXiv:1805.06334, 2018 more…

Multi-Task-Lernen

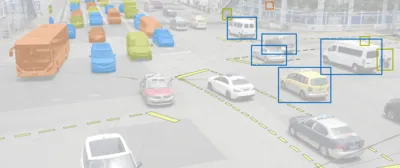

Viele Anwendungen wie die Interpretation von Straßenräumen für das autonome Fahren erfordern die Lösung verschiedener Aufgaben (Tasks) basierend auf Sensorbeobachtungen wie digitalen optischen Bildern. Die zu extrahierenden Informationen spiegeln dabei typischerweise verschiedene Aspekte identischer Objekte der physischen Welt wieder. Dieses Wissen um bestehende Korrelationen zwischen den Tasks kann ausgenutzt werden um die einzelnen Tasks effizienter und mit höherer Genauigkeit lösen zu können.

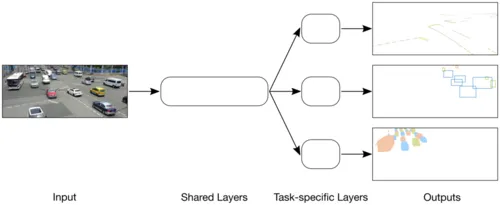

Künstliche Neuronale Netzwerke für Multi-Task-Lernen

Künstliche neuronale Netzwerke zur Bildverarbeitung (Convolutional Neural Networks, CNNs) stellen den aktuellen Stand der Technik in nahezu allen relevanten Tasks dar. Das übliche feed-forward end-to-end Schema kann für multi-task learning erweitert werden. Dazu wird das Netzwerk in einen gemeinsamen Teil, der für alle Tasks genutzt wird, und task-spezifische Teile aufgeteilt. Der gemeinsame Teil, der typischerweise die anfänglichen Schichten und einen Großteil der Parameter der Netzwerkarchitektur umfasst, kann dabei als Merkmalsextraktor interpretiert werden. Die task-spezifischen Schichten, die auf den jeweiligen Task angepasst sind, bauen auf diese Repräsentation der Eingabedaten auf und wandeln sie in die gewünschte Ausgabe um. Da die Parameter des gemeinsamen Teiles gleichzeitig für alle Tasks optimiert werden, sind multi-task Systeme nicht nur effizient sondern häufig auch besonders robust.

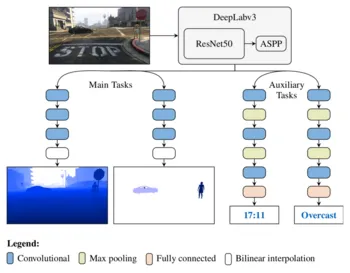

Ergänzende Tasks

In verwandten Arbeiten konnte bereits gezeigt werden, dass die von multi-task Netzwerken erzielten Ergebnisse die Qualität von herkömmlichen Netzwerkarchitekturen übertreffen können. In Liebel & Körner (2018) wird ein neuartiger Ansatz vorgestellt in dem unterstützende Tasks (Auxiliary Tasks) während des Trainings zum System hinzugefügt werden, die für die tatsächliche Anwendung zur Testzeit weniger relevant oder sogar gänzlich irrelevant sind. Auxiliary Tasks unterstützen damit den Optimierungsprozess indem die Entwicklung eines robusten und generischen Parametersatzes gefördert wird. Um den Trainingsprozess nicht unnötig zu erschweren, werden als Auxiliary Tasks einfache Tasks gewählt, für die ohne großen Mehraufwand Referenzdaten für das Training bereitgestellt werden können. In ersten Experimenten für das Anwendungsbeispiel der Interpretation von Straßenräumen wurden als zur Testzeit erforderliche Tasks (Main Tasks) die pixelweise Tiefenschätzung sowie die semantische Segmentierung des Bildes gewählt. Zusätzlich wurden als Auxiliary Tasks die Schätzung der aktuellen Uhrzeit sowie die Klassifizierung der aktuellen Witterungsbedingungen in das multi-task System eingeführt.

Synthetische Trainingsdaten

Für das Training von tiefen Netzwerken werden große Mengen an, zumeist manuell annotierten, Referenzdaten (Labels) benötigt. Um ein multi-task System trainieren zu können werden darüber hinaus gleich mehrere Labels pro Bild benötigt. Da aktuell verfügbare Datensätze in dieser Hinsicht stark eingeschränkt sind, kann zur Entwicklung und Evaluierung der vorgestellten Ansätze auf synthetische Daten zurückgegriffen werden. Jüngste Fortschritte im Bereich der Computergraphik ermöglichen heute die Erzeugung von nahezu photorealistischen Bildern und interaktive Simulation komplexer Szenarien in Echtzeit. Labels wie Tiefenkarten und globale wie auch pixelweise semantische Informationen können vollautomatisch zusammen mit dem simulierten Bild ausgegeben werden. Die Nutzung moderner Videospiele zu diesem Zweck erfreut sich zunehmender Beliebtheit.

Speziell zugeschnitten auf die Bedürfnisse von multi-task Systemen ist der in Liebel & Körner (2018) vorgestellte Datensatz synMT, der je 21 Labels für etwa 250 000 Bilder bereitstellt. Die Daten wurden aus dem Videospiel „Grand Theft Auto V“ extrahiert und enthalten unter anderem auch die Eingabebefehle des Fahrers, der das simulierte Fahrzeug mit Hilfe spezieller Eingabegeräte (Lenkrad und Pedale) steuerte.